LSTM之父22年前构想将成真?一周内AI「自我进化」论文集中发布,新趋势涌现?

LSTM之父22年前构想将成真?一周内AI「自我进化」论文集中发布,新趋势涌现?在过去的一周,这一方向的进展尤其丰富。有人发现,几篇关于「让 LLM(或智能体)学会自我训练」的论文在 arXiv 上集中出现,其中甚至包括受「哥德尔机」构想启发而提出的「达尔文哥德尔机」。或许,AI 模型的自我进化能力正在加速提升。

在过去的一周,这一方向的进展尤其丰富。有人发现,几篇关于「让 LLM(或智能体)学会自我训练」的论文在 arXiv 上集中出现,其中甚至包括受「哥德尔机」构想启发而提出的「达尔文哥德尔机」。或许,AI 模型的自我进化能力正在加速提升。

LM Arena 是一个众包基准测试项目,各大 AI 实验室依赖其测试和推广自家 AI 模型。据彭博社报道,该项目已在种子轮融资中筹集 1 亿美元 ,估值达 6 亿美元。

MCP 是一种开放的技术协议,旨在标准化大型语言模型(LLM)与外部工具和服务的交互方式。你可以把 MCP 理解成像是一个 AI 世界的通用翻译官,让 AI 模型能够与各种各样的外部工具"对话"。

AI 初创公司 Stability AI 发布了名为 Stable Audio Open Small 的“立体声”音频生成 AI 模型,该公司宣称这是市场上速度最快的模型,且效率高到足以在智能手机上运行。

Anthropic 推出了一项新 API,使其 Claude AI 模型能够进行全网搜索。该公司在 5 月 7 日发布的新闻稿中表示,开发者利用此 API 可构建基于 Claude 的应用,提供最新信息。

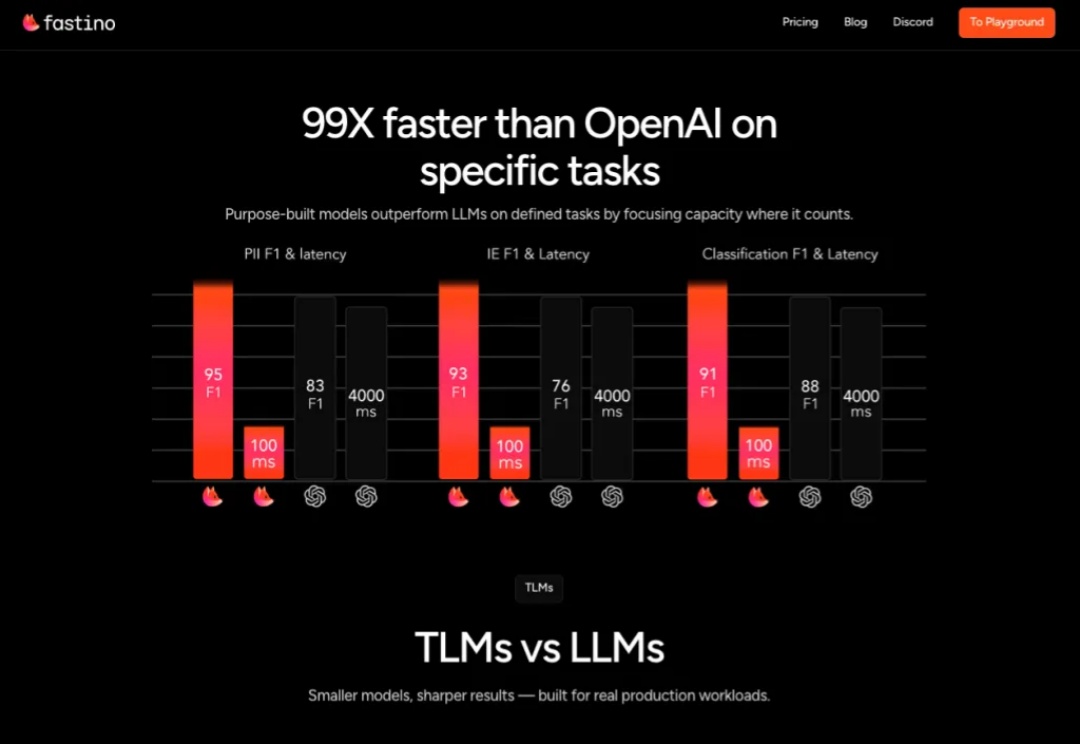

科技巨头常吹嘘需要庞大昂贵GPU 集群的万亿参数 AI 模型,但 Fastino 正采取截然不同的策略

外媒报道,Manus 最近完成了一轮由美国风险投资公司 Benchmark 领投的 7500 万美元的融资。蝴蝶效应计划利用这笔资金将其服务扩展到包括美国、日本和中东在内的其他市场。据 The Information 上周报道,Manus 使用 Anthropic 的 Claude AI 模型及其他工具,平均每个任务需向 Anthropic 支付 2 美元。

两名没有高度专业 AI 知识的本科生表示,他们已经创建了一个公开可用的 AI 模型,可以生成类似于 Google 的 NotebookLM 的播客风格的剪辑。

科技媒体 maginative 今天(4 月 16 日)发布博文,报道称 OpenAI 宣布收购 Context.ai团队,后者是一家由 GV 支持的初创公司,以评估和分析 AI 模型见长。Context.ai的联合创始人 Henry Scott-Green(首席执行官)和 Alex Gamble(首席技术官)将加入 OpenAI,专注于研发模型评估工具。

传统科技公司、尤其是 2B 的公司,其信息、视觉传达都是以公司、产品、技术创新为中心的。但是,处在现代最前沿技术之一的 AI 公司,似乎想做一些不一样的传达。我们将近距离看一下 OpenAI,Cohere,Anthropic 这三家 AI 模型公司的信息、视觉传达,看看他们怎么是从传统科技公司的风格中,做出一些不一样的、以人为本的品牌设计的。